Recomendaciones para disfrutar del eclipse del próximo Eclipse Solar Total del 2 de Julio del 2019

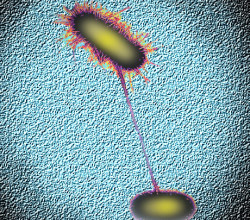

El fenómeno astronómico Un evento donde la alineación del Sol, Luna y la Tierra, provocarán una sombra de aproximadamente 150 km de ancho que atravesará el norte de la Región...